Costa Rica será sede del XIV EBAM

/en Eventos, La Escuela, Reseñas /por Escuela de Historia

Dr. Alejandro Bonilla Castro y M.Sc. Raquel Umaña Alpízar

Costa Rica será sede del XIV Encuentro Latinoamericano de Bibliotecarios, Archivistas y Museólogos (EBAM)

El EBAM se unirá con el XXXVI Congreso Archivístico Nacional que tendrá lugar este mes de julio.

El XXXVI Congreso Archivístico Nacional se ha fusionado con el EBAM para crear un evento gratuito y singular que integrará diversas disciplinas y ofrecerá una plataforma para el intercambio de conocimientos y experiencias

19 julio 2024

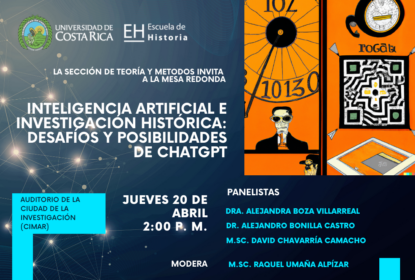

San José, Costa Rica – Este año, Costa Rica se prepara para recibir la 14ª edición del Encuentro Latinoamericano de Bibliotecarios, Archivistas y Museólogos (EBAM), que tendrá lugar del 22 al 24 de julio en la Universidad de Costa Rica. Este evento, cuyo lema central es “Un desarrollo igualitario en América: Información sin barreras”, promete ser un hito en la formación continua y la investigación en las áreas de bibliotecología, archivística y museología.

El EBAM está siendo organizado por la Escuela de Bibliotecología y Ciencias de la Información de la Universidad de Costa Rica, en colaboración con el Proyecto ED2794 Formación Archivística Continua de la Sección de Archivística de la Escuela de Historia, el Museo UCR, el Archivo Nacional y la Biblioteca Nacional de Costa Rica. En un esfuerzo por maximizar el impacto y la colaboración, el XXXVI Congreso Archivístico Nacional se ha fusionado con el EBAM para crear un evento gratuito y singular que integrará diversas disciplinas y ofrecerá una plataforma para el intercambio de conocimientos y experiencias.

Programa y Actividades

El evento contará con un variado programa de aproximadamente 44 actividades, incluyendo ponencias, sesiones plenarias, clases magistrales, talleres y cursos. Entre los temas destacados se encuentran:

-

- La información para combatir la desigualdad: acción individual y colectiva para la sostenibilidad y equidad.

- La construcción de proyectos colaborativos para promover la interoperabilidad semántica y la evaluación funcional de la información: la experiencia portuguesa. Gobernanza de datos en el contexto archivístico actual.

- Gestión de riesgos documentales.

- Clasificación y evaluación funcional de la información archivística y modelo ontológico asociado.

- Inteligencia Artificial: retos y oportunidades.

- Evaluación de datos abiertos desde la perspectiva de la OCDE y el Barómetro Global de Datos.

El EBAM se constituye como una experiencia de trabajo colaborativo interdisciplinario que fortalecerá la formación académica en bibliotecología, archivística y museología, brindando acceso a nuevas tecnologías y metodologías innovadoras, colaboraciones futuras y oportunidades de crecimiento personal

Invitados Especiales

La M.Sc. Raquel Umaña Alpízar, docente de la Sección de Archivística de la Escuela de Historia, señaló que el evento contará con la presencia de dos reconocidos expertos internacionales en Archivística:

- Dr. Pedro Pereira Penteado: Director de Servicios Archivísticos y Normalización de la Dirección General del Libro, Archivos y Bibliotecas de Portugal. Es un especialista en gestión y preservación de información digital, y en interoperabilidad de datos. Penteado también ha coordinado directrices para la gestión de documentos de archivo en el contexto de la reestructuración de la administración central del Estado portugués.

- Dra. Anahí Casadesús de Mingo: Doctora y docente de la Escuela Superior de Archivística y Gestión de Documentos de la Universidad Autónoma de Barcelona. Es miembro de InterPares y experta en inteligencia artificial aplicada a la archivística. Su tesis doctoral sobre la gestión del riesgo en la gestión de documentos y su impacto en la rendición de cuentas públicas ha sido pionera en el campo.

Importancia del Evento

En el marco del 50 aniversario de la Facultad de Ciencias Sociales de la Universidad de Costa Rica, este evento internacional espera recibir más de 400 participantes tanto nacionales como internacionales. La profesora Umaña, destacó la importancia del EBAM como una experiencia de trabajo colaborativo interdisciplinario que fortalecerá la formación académica en bibliotecología, archivística y museología, brindando acceso a nuevas tecnologías y metodologías innovadoras, colaboraciones futuras y oportunidades de crecimiento personal.

La Universidad de Costa Rica está proporcionando el espacio necesario para las actividades incluyendo el Auditorio de la Investigación (CIMAR), así como las aulas, auditorios y áreas de trabajo en la Facultad de Ciencias Sociales, la cual, también brindará el apoyo técnico y logístico para la transmisión en vivo de las conferencias magistrales en YouTube, ampliado así el alcance social y académico del evento.